В среду консорциум MLCommons опубликовал результаты эталонного тестирования MLPerf Inference v4.1 для популярных ускорителей вывода AI, доступных на рынке, от таких производителей, как NVIDIA, AMD и Intel. Ускорители AMD Instinct MI300X оказались конкурентоспособными по отношению к AI-GPU серии NVIDIA «Hopper» H100. AMD также воспользовалась этой возможностью, чтобы продемонстрировать, как клиенты могут ожидать повышение производительности вывода AI от своих серверных процессоров EPYC следующего поколения «Turin», работающих на этих машинах MI300X. «Turin» оснащен ядрами CPU «Zen 5», обладающими 512-битным каналом FPU и улучшенной производительностью в наборах инструкций SIMD с 512-битной шириной, которые актуальны для AI, таких как AVX-512 и VNNI. MI300X, с другой стороны, опирается на сильные стороны своей подсистемы памяти, поддержку формата данных FP8 и эффективное управление кэшем KV.

Эталонное тестирование MLPerf Inference v4.1 было сосредоточено на модели LLaMA2-70B с 70 миллиардами параметров. В список тестовых машин AMD вошли те, которые оснащены Instinct MI300X, работающими на текущих процессорах EPYC «Genoa» (Zen 4) и процессорах EPYC «Turin» (Zen 5) следующего поколения. Графические процессоры поддерживаются открытым программным стеком ROCm от AMD. В эталонном тестировании оценивалась производительность вывода с использованием 24 576 образцов вопросов и ответов из набора данных OpenORCA, где каждый образец содержит до 1024 входных и выходных токенов. Было оценено два сценария: автономный сценарий, сосредоточенный на пакетной обработке для максимальной пропускной способности в токенах в секунду, и серверный сценарий, который имитирует запросы в реальном времени с жесткими ограничениями по задержкам (TTFT ≤ 2 секунды, TPOT ≤ 200 мс).

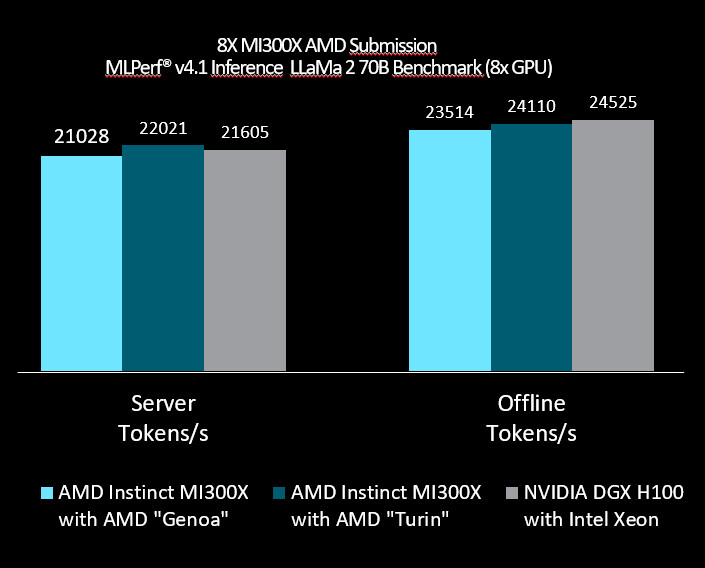

Это позволяет увидеть, как чип справляется как с запросами с высокой пропускной способностью, так и с запросами с низкой задержкой. В первом тесте AMD (4.1-0002) участвует сервер, оснащенный 2-процессорной конфигурацией EPYC 9374F «Genoa» и 8x ускорителями Instinct MI300X. Здесь машина выдает 21 028 токенов/с в серверном тесте, по сравнению с 21 605 токенов/с, показанных машиной NVIDIA, сочетающей 8x NVIDIA DGX100 с процессором Xeon. В автономном тесте машина AMD показывает 23 514 токенов/с по сравнению с 24 525 токенов/с машины NVIDIA+Intel. AMD протестировала 8x MI300X с парой процессоров EPYC «Turin» (Zen 5) со сравнимым количеством ядер и обошла NVIDIA, показав 22 021 токен/с в серверном тесте и 24 110 токенов/с в автономном тесте. AMD утверждает, что достигает почти линейного масштабирования производительности между 1x MI300X и 8x MI300X, что говорит о мастерстве AMD в области ввода-вывода платформы и управления памятью. Результаты AMD сулят хорошие перспективы для будущих версий модели, таких как LLaMA 3.1 с ее огромными 405 миллиардами параметров.

В этом случае 192 ГБ HBM3 с пропускной способностью памяти 5,3 ТБ/с очень кстати. Это принесло AMD партнерство с Meta для работы с LLaMa 3.1 405B. 8-процессорный модуль MI300X оснащен 1,5 ТБ памяти с пропускной способностью более 42 ТБ/с, а Infinity Fabric обеспечивает взаимосвязь. Один сервер может разместить всю модель LLaMa 3.1 405B с использованием типа данных FP16.