Компания SK hynix продемонстрировала свое усовершенствованное решение для ИИ-памяти AiM (Acceleration-in-Memory) на конференции AI Infra Summit 2025, которая прошла в Санта-Кларе, Калифорния. Мероприятие собрало более 3500 лидеров мирового ИИ-сообщества и сфокусировалось на теме «Питание быстрого, эффективного и доступного ИИ», где SK hynix подчеркнула свое технологическое лидерство в будущих ИИ-сервисах.

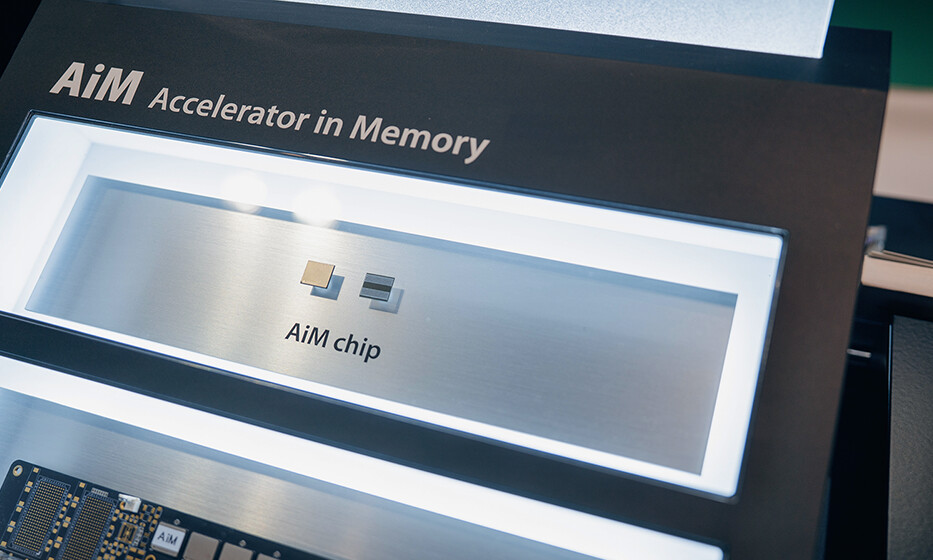

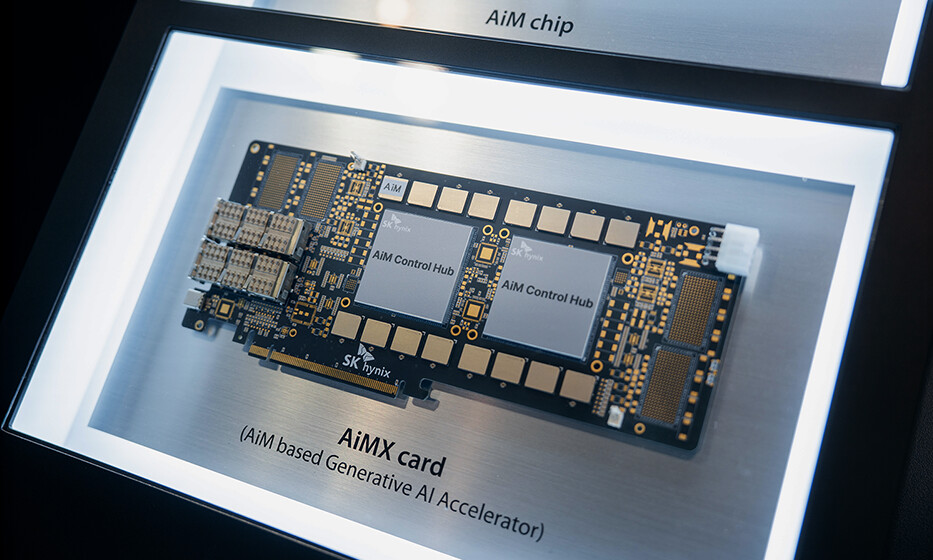

На стенде, работающем под лозунгом «Ускорь свой ИИ: AiM — это все, что вам нужно», компания представила последние разработки своего PIM-решения (Processing-in-Memory) под названием AiMX. В рамках живой демонстрации, посетители могли увидеть серверную систему Supermicro, оснащенную двумя графическими процессорами NVIDIA H100 и четырьмя картами AiMX. Это позволило наглядно оценить технологические возможности и конкурентоспособность AiM в реальных условиях.

Демонстрация была сфокусирована на преодолении так называемой «стены памяти» при инференсе больших языковых моделей (LLM). В традиционных системах, использующих только GPU, этапы, ограниченные вычислительной мощностью (compute-bound), и этапы, ограниченные памятью (memory-bound), обрабатываются совместно, что приводит к неэффективности по мере увеличения запросов пользователей или контекстной длины.

В отличие от этого, дезагрегированная система инференса на базе AiMX разделяет рабочую нагрузку на два отдельных этапа: памятезависимый этап выполняется на ускорителе AiMX, а вычислительный этап — на GPU. Такое разделение позволяет системе одновременно обрабатывать больше запросов и более длинные входные промпты, значительно повышая пропускную способность.

SK hynix также представила важные программные улучшения для своих карт AiMX. Применение широко используемого фреймворка vLLM для разработки ИИ-сервисов не только расширило функциональность решения, но и обеспечило стабильную поддержку генерации длинных токенов даже в сложных моделях, требующих интенсивного процесса рассуждений. Благодаря обновленной архитектуре и усовершенствованному программному обеспечению, новое решение на базе AiM эффективно решает проблемы стоимости, производительности и энергопотребления при управлении LLM-сервисами, сокращая эксплуатационные расходы по сравнению с системами, работающими исключительно на GPU.

В рамках саммита вице-президент Ыйчоль Лим, глава отдела передовых решений, выступил с презентацией, в которой подробно изложил методы снижения затрат на обработку токенов в LLM-сервисах и подчеркнул влияние технологий ИИ-памяти на цифровую трансформацию индустрии. SK hynix подтвердила свою приверженность укреплению технологического лидерства за счет предоставления новых решений в области памяти для решения актуальных задач будущих ИИ-сервисов.