На конференции SC24 компания NVIDIA анонсировала свой новейший вычислительный ускоритель для задач искусственного интеллекта — GB200 NVL4. Это серверное решение расширяет портфолио серии «Blackwell» и объединяет на одной плате четыре графических процессора «Blackwell» и два центральных процессора «Grace».

GB200 NVL4 обладает впечатляющими характеристиками для односерверной системы. Четыре GPU Blackwell оснащены 768 ГБ памяти HBM3E с общей пропускной способностью 32 ТБ/с. Два CPU Grace располагают 960 ГБ памяти LPDDR5X, что делает систему невероятно мощной для ресурсоемких задач ИИ. Ключевой особенностью NVL4 является технология межсоединений NVLink, обеспечивающая связь между всеми процессорами на плате. Эта интеграция критически важна для поддержания оптимальной производительности всех вычислительных блоков системы, особенно при больших циклах обучения или работе с многотриллионными параметрами моделей. Сравнение производительности с предыдущими поколениями демонстрирует значительный прогресс.

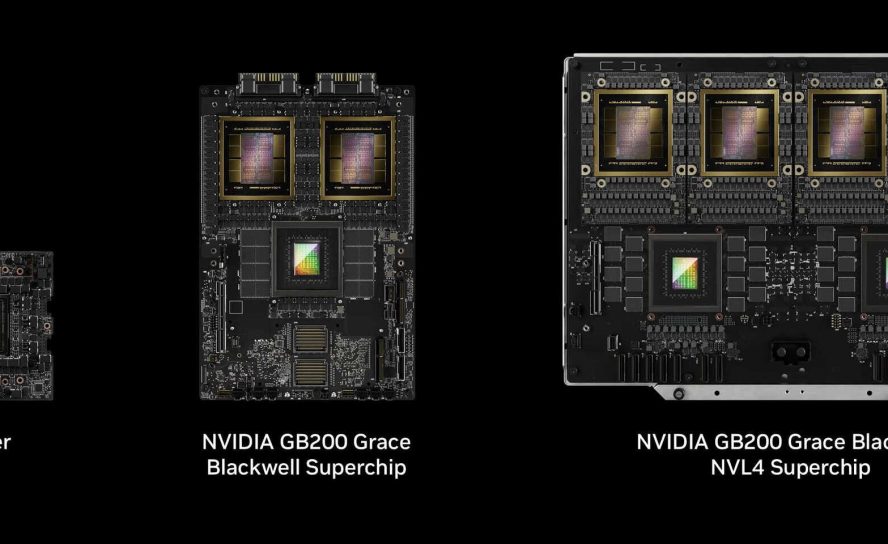

По заявлениям NVIDIA, GPU GB200 обеспечивают в 2,2 раза более высокую общую производительность и в 1,8 раза более быстрое обучение по сравнению с предшественником GH200 NVL4. Энергопотребление системы достигает 5400 Вт, что вдвое больше, чем у модели GB200 NVL2 с двумя GPU. NVIDIA тесно сотрудничает с OEM-партнерами для вывода на рынок различных решений Blackwell, включая DGX B200, GB200 Grace Blackwell Superchip, GB200 Grace Blackwell NVL2, GB200 Grace Blackwell NVL4 и GB200 Grace Blackwell NVL72. Для обеспечения оптимальной работы системы с TDP 5400 Вт потребуется жидкостное охлаждение. Ожидается, что GB200 NVL4 будет использоваться в серверных стойках гипермасштабируемых клиентов, которые обычно имеют собственные системы жидкостного охлаждения в своих дата-центрах.