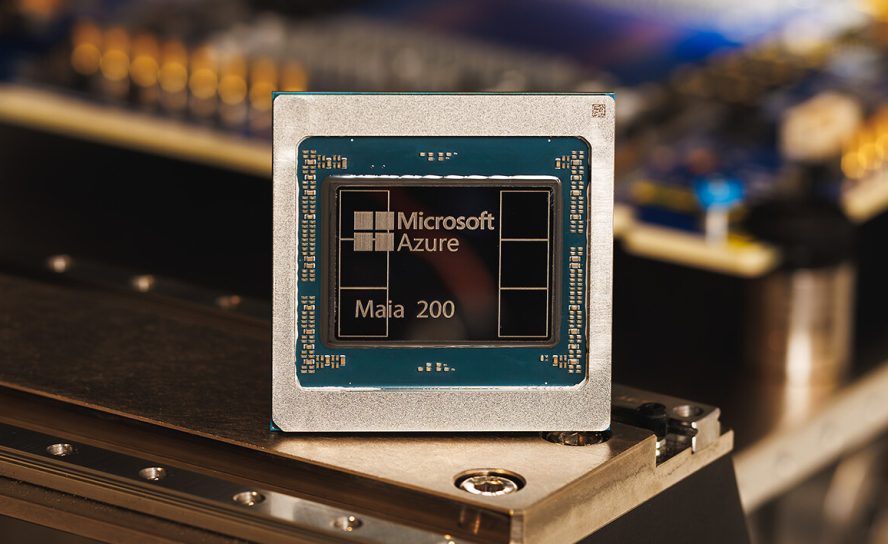

Microsoft официально представила Maia 200 — собственный ускоритель инференса, который компания называет самым производительным и экономически эффективным первым поколением кремния, созданного гиперскейлером для задач генерации токенов ИИ. Новый чип разработан как ключевой элемент гетерогенной ИИ-инфраструктуры Microsoft и уже используется для обслуживания крупных моделей, включая новейшие GPT-5.2 от OpenAI, а также внутренних разработок команды Microsoft Superintelligence.

Maia 200 производится по передовому 3-нанометровому техпроцессу TSMC и содержит более 140 миллиардов транзисторов. Архитектура изначально ориентирована на инференс современных моделей с пониженной точностью вычислений. Ускоритель оснащён тензорными блоками с нативной поддержкой FP8 и FP4 и способен обеспечивать свыше 10 петафлопс производительности в FP4 и более 5 петафлопс в FP8, укладываясь в тепловой пакет 750 Вт на SoC. По заявлению Microsoft, по FP4-производительности Maia 200 втрое превосходит Amazon Trainium третьего поколения, а по FP8 — опережает TPU седьмого поколения от Google. При этом компания подчёркивает 30-процентное преимущество по показателю «производительность на доллар» по сравнению с самым свежим оборудованием в текущем парке Azure.

Отдельный акцент сделан на подсистеме памяти, которая часто становится узким местом при инференсе крупных языковых моделей. Maia 200 получила 216 ГБ HBM3e с пропускной способностью до 7 ТБ/с, дополненные 272 МБ встроенной SRAM и специализированными механизмами перемещения данных. Такая конфигурация рассчитана на стабильную подачу данных к вычислительным блокам и рост пропускной способности при генерации токенов, что напрямую влияет на задержки и общую эффективность.

На уровне системы Microsoft реализовала двухуровневую масштабируемую сеть на базе стандартного Ethernet. Собственный транспортный уровень и тесная интеграция сетевых контроллеров позволяют отказаться от проприетарных фабрик, сохраняя при этом высокую предсказуемость коллективных операций и снижая совокупную стоимость владения. Каждый ускоритель предоставляет до 2,8 ТБ/с двунаправленной полосы пропускания для scale-up-соединений, а архитектура рассчитана на кластеры до 6144 ускорителей. Внутри одного трейа четыре чипа Maia соединены прямыми линками без коммутаторов, что минимизирует задержки и повышает эффективность инференса.

Maia 200 уже развернут в дата-центре Microsoft в регионе US Central рядом с Де-Мойном, а следующим станет кластер US West 3 в районе Финикса. Ускоритель глубоко интегрирован с Azure, а для разработчиков доступен предварительный набор инструментов Maia SDK. Он включает поддержку PyTorch, компилятор Triton, оптимизированные библиотеки ядер и низкоуровневый язык программирования Maia, что упрощает перенос моделей между различными аппаратными ускорителями и даёт возможность тонкой оптимизации.

Microsoft подчёркивает, что Maia 200 разрабатывался с облачно-ориентированным подходом, где чип, сеть, программное обеспечение и инфраструктура дата-центра проектировались как единое целое. Благодаря этому первые ИИ-модели были запущены на новом ускорителе уже через несколько дней после получения первых серийных образцов, а путь от «первого кремния» до промышленного развёртывания оказался более чем вдвое короче по сравнению с аналогичными программами. В компании считают, что именно такой сквозной подход позволит и дальше повышать эффективность, ускорять вывод ИИ-сервисов в продакшен и улучшать показатели производительности на ватт и на доллар в масштабах облака.