DeepSeek-R1, передовая модель с впечатляющими возможностями рассуждения, теперь доступна в предварительной версии в качестве микросервиса NVIDIA NIM на build.nvidia.com. В отличие от моделей, дающих прямые ответы, DeepSeek-R1 использует многопроходный вывод, цепочки рассуждений, консенсус и методы поиска для генерации наилучшего ответа. Этот процесс, известный как масштабирование во время тестирования (test-time scaling), демонстрирует важность ускоренных вычислений для агентивного ИИ.

DeepSeek-R1 — отличный пример эффективности масштабирования во время тестирования. По мере того, как модели получают возможность итеративно «продумывать» задачу, они генерируют больше выходных токенов и более длинные циклы генерации, что повышает качество модели. Значительные вычислительные ресурсы во время тестирования критически важны для обеспечения как вывода в реальном времени, так и более качественных ответов от моделей рассуждения, таких как DeepSeek-R1, что требует более крупных развертываний для вывода. R1 обеспечивает ведущую точность для задач, требующих логического вывода, рассуждений, математических вычислений, кодирования и понимания языка, а также высокую эффективность вывода.

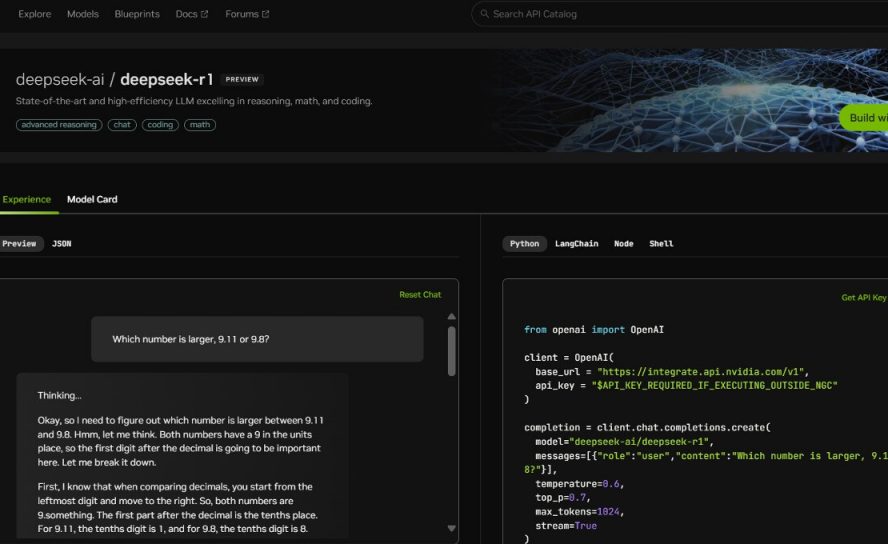

Микросервис DeepSeek-R1 NIM может обрабатывать до 3872 токенов в секунду на одной системе NVIDIA HGX H200. Разработчики могут тестировать и экспериментировать с API, который вскоре будет доступен для скачивания в качестве микросервиса NIM, являющегося частью программной платформы NVIDIA AI Enterprise. Микросервис DeepSeek-R1 NIM упрощает развертывание благодаря поддержке отраслевых стандартных API. Предприятия могут максимизировать безопасность и конфиденциальность данных, запуская микросервис NIM на предпочитаемой ими инфраструктуре ускоренных вычислений. Используя NVIDIA AI Foundry с программным обеспечением NVIDIA NeMo, предприятия также смогут создавать настраиваемые микросервисы DeepSeek-R1 NIM для специализированных агентов ИИ.

DeepSeek-R1: масштабирование во время тестирования в действии

DeepSeek-R1 — это большая модель со смесью экспертов (MoE), содержащая 671 миллиард параметров — в 10 раз больше, чем многие другие популярные LLM с открытым исходным кодом, — и поддерживающая большую длину входного контекста в 128 000 токенов. Каждый слой R1 имеет 256 экспертов, причем каждый токен направляется параллельно к восьми отдельным экспертам для оценки.

Для обеспечения ответов R1 в реальном времени требуется множество графических процессоров с высокой вычислительной производительностью, соединенных высокоскоростной связью с низкой задержкой для маршрутизации токенов запроса ко всем экспертам для вывода. В сочетании с программной оптимизацией, доступной в микросервисе NVIDIA NIM, один сервер с восемью графическими процессорами H200, подключенными с помощью NVLink и NVLink Switch, может запускать полную модель DeepSeek-R1 с 671 миллиардом параметров со скоростью до 3872 токенов в секунду. Эта пропускная способность достигается за счет использования движка FP8 Transformer Engine архитектуры NVIDIA Hopper на каждом слое и пропускной способности NVLink 900 ГБ/с для связи между экспертами MoE.

Получение максимальной производительности с каждого графического процессора имеет решающее значение для вывода в реальном времени. Архитектура NVIDIA Blackwell следующего поколения значительно улучшит масштабирование во время тестирования для моделей рассуждения, таких как DeepSeek-R1, благодаря тензорным ядрам пятого поколения, которые могут обеспечить пиковую вычислительную производительность FP4 до 20 петафлопс, и домену NVLink на 72 графических процессора, специально оптимизированному для вывода.