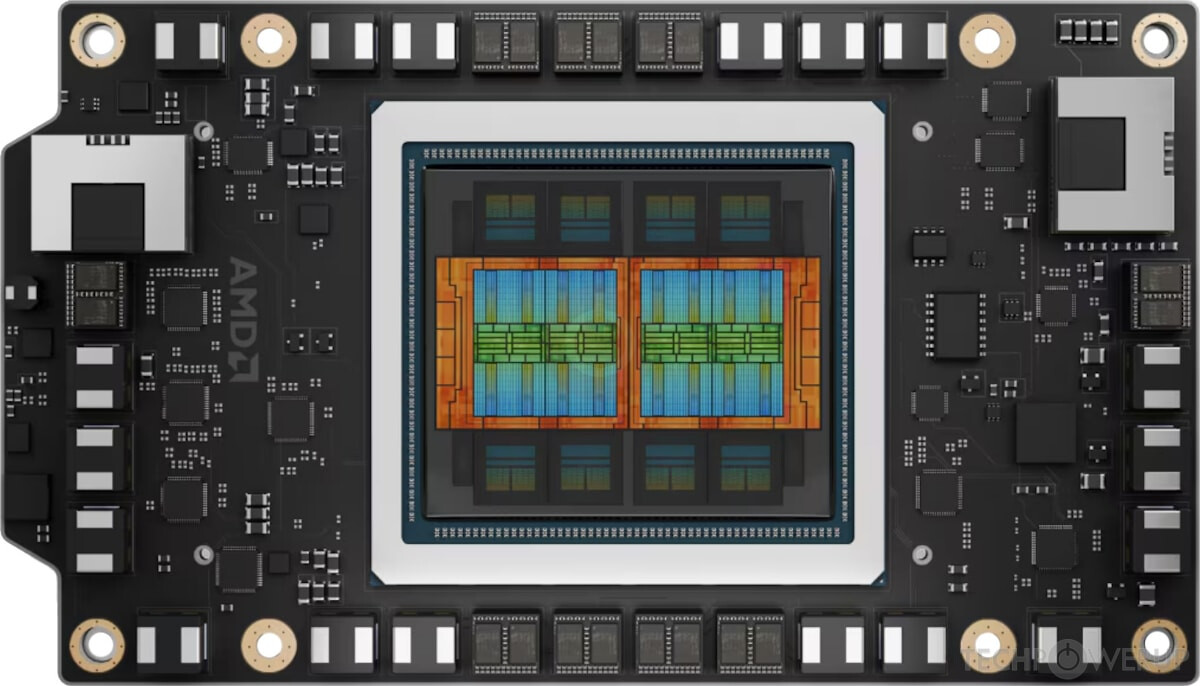

На фоне стремительного роста нагрузок, связанных с генеративным ИИ и большими языковыми моделями, AMD рассказала о существенном прогрессе в оптимизации инференс-инфраструктуры для современных сценариев рассуждений и агентных рабочих процессов. Компания делает ставку не только на универсальные фреймворки вроде vLLM и SGLang, но и на собственный специализированный движок ATOM, который, по заявлению разработчиков, позволяет наиболее полно раскрыть возможности ускорителей Instinct MI355X в задачах, насыщенных MoE-архитектурами и многошаговыми вычислениями.

За последние месяцы инженеры AMD сосредоточились на повышении эффективности как одиночных узлов, так и распределённых конфигураций при работе с моделью DeepSeek-R1 — открытым reasoning-ориентированным LLM, активно использующим MLA-внимание и разреженные MoE-эксперты. Ключом к росту производительности стало сочетание глубоко оптимизированных и объединённых вычислительных ядер для основных примитивов LLM, лёгкого инференс-движка ATOM с управлением планированием, батчингом и KV-кэшем, а также доработанной поддержки распределённого инференса. Сам ATOM был выложен в открытый доступ и может использоваться как самостоятельное решение или в роли бэкенда для популярных фреймворков.

В сценариях одиночного узла MI355X с ATOM демонстрирует стабильную и высокую производительность при различных уровнях параллелизма, включая режимы, критически важные для снижения стоимости токена в промышленных развёртываниях. По данным AMD, на высоких уровнях конкурентности ускоритель способен соответствовать или превосходить системы на базе NVIDIA Blackwell B200, работающие с существующими инференс-фреймворками, сохраняя преимущества при разных длинах последовательностей — от интерактивных диалогов до длительной генерации.

Не менее убедительно MI355X выглядит и в распределённых конфигурациях. Оптимизированная обработка MoE-диспетчеризации, агрегации экспертов и трафика KV-кэша позволяет GPU эффективно масштабироваться на несколько узлов. В чувствительных к задержкам сценариях, характерных для пользовательских сервисов, решения AMD показывают более высокий выход токенов на GPU при сопоставимой интерактивности, что делает платформу привлекательной для real-time инференса. При этом поддерживаются продвинутые стратегии параллелизма, включая экспертный параллелизм и разделение стадий prefill и decode.

В AMD подчёркивают, что работа над оптимизациями продолжается. В ближайших планах — дальнейшее исследование конфигураций с большим числом экспертов, углублённая фьюзия операторов для крупных MoE-моделей и улучшение обслуживания длинных контекстов. Все описанные наработки уже интегрированы в открытое ПО, что позволяет сообществу воспроизводить результаты и адаптировать ATOM под собственные задачи.

Суммируя итоги, AMD позиционирует Instinct MI355X как конкурентоспособную и открытую платформу для следующей волны GenAI-инференса, где решающую роль играют масштабируемость, эффективность и прозрачность программной экосистемы. Компания уточняет, что приведённые данные основаны на внутренних измерениях по состоянию на декабрь 2025 года и носят информационный характер.